AI 2027; sacrée mise en garde sur l’IA aux capacités surhumaines

La sortie d’un texte rédigé par un groupe de chercheurs dans l’intelligence artificielle vient peut-être de complètement chambarder cette idée rassurante selon laquelle la super intelligence artificielle serait encore très loin dans l’avenir. Risque-t-on de perdre tout control sur cette technologie et de nous enfoncer dans un scénario catastrophique ?

Depuis quelques années on assiste, souvent avec un certain étonnement, aux progrès dans les capacités des assistants personnels virtuels et des agents conversationnels, les soi-disant chatbots en anglais, c’est-à-dire de technologies qui sont le produit de la recherche dans l’intelligence artificielle. La sortie de ChatGPT, lancé en 2022, a par exemple été une véritable révolution dans toute une gamme de domaines. Ses capacités de répondre à des requêtes d’information, de synthétiser et de rédiger des textes d’une très bonne qualité, de tenir des conversations qui simulent de façon réaliste des conversations avec des personnes réelles, de générer du code informatique, tout ça a fortement impressionné le public, suscitant même des inquiétudes parmi certains sur des risques de détournement à des fins douteux – désinformation, plagiat, etc.- de cette technologie émergente.

J’ai néanmoins souvent entendu certains spécialistes du domaine dire, parfois avec un brin d’ironie, que même si le niveau de sophistication atteint par ces systèmes d’intelligence artificielle est tout à fait extraordinaire, il ne faut pas craindre que le développement de ces systèmes soit sur le point d’arriver à un stade où ils risqueraient d’échapper au contrôle de leurs créateurs. Selon eux, l’intelligence artificielle générale, c’est-à-dire une forme de super intelligence artificielle capable de réaliser et d’apprendre pratiquent n’importe quelle tâche cognitive aussi bien que les êtres humains, relève d’une science-fiction qui appartiendrait encore à un avenir plutôt lointain, sous entendant qu’il y a encore du temps pour peaufiner et rectifier les défaillances dans ces systèmes pour empêcher des scénarios alarmants.

Une prévision inquiétante

La sortie d’un texte rédigé par un groupe de chercheurs du domaine, certains travaillant ou ayant travaillé avec les plus grandes entreprises de recherche dans l’intelligence artificielle, vient pourtant de complètement chambarder cette idée rassurante selon laquelle la super intelligence artificielle serait encore très loin dans l’avenir. D’après le scénario dépeint par ces chercheurs, l’arrivée de ces systèmes super intelligents n’est qu’une question de quelques années, et les éventualités qu’ils décrivent dans cette mise en garde publiée en avril dernière suscitent pas mal d’inquiétude. Le temps presse, et on ne serait pas prêts à suivre le rythme de (auto) développement de ces systèmes, et encore moins prêts à répondre au bouleversement social qu’il va entraîner. Une course à l’armement a apparemment déjà été déclenchée en coulisses entre des entreprises technologiques américaines et chinoises pour arriver à être le premier à posséder cette technologie susceptible de bouleverser le monde tel qu’on le connaît, car celui qui réussit à le faire pourrait en théorie devenir le détenteur de capacités tellement supérieures et au dessus de tout ce que l’on a connu auparavant dans pratiquement tous les domaines, y compris recherche scientifique, défense, industrialisation, production, codage, robotique, capacités de prévision, qu’il aurait une avantage impossible à rattraper au moment où l’on rentre dans une nouvelle ère du développement technologique de l’humanité. Ce ne serait peut-être pas de l’hyperbole de parler de…maître du monde. Pis encore, la technologie pourrait complètement échapper à notre contrôle, et l’on se retrouverait tout à coup dans une situation dans laquelle notre existence même en tant qu’espèce serait menacée.

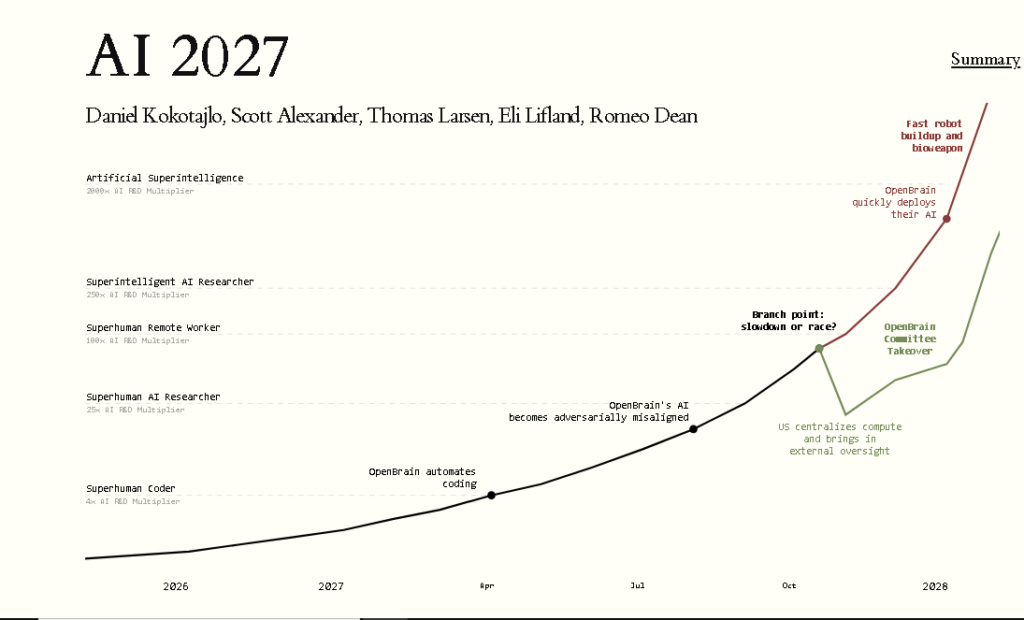

Le texte s’appelle AI 2027. L’équipe qui l’a rédigé est menée par Daniel Kokotajlo, un ancien chercheur chez l’entreprise de recherche technologique Open AI, devenu célèbre il y a quelques temps pour risquer de perdre des millions de dollars de capitaux propres dans l’entreprise à cause de son refus de signer un accord de confidentialité abusif suivant sa décision de démissionner pour des raisons éthiques. La phrase d’ouverture du scénario donne quand même une tonique sinistre dès le départ : « On prévoit que l’impact de l’intelligence artificielle surhumaine dans la décennie à venir sera énorme, surpassant celui de la révolution industrielle. » Il décrit de façon détaillée comment les progrès dans le domaine seront perçus et reçus par différents acteurs entrepreneuriaux, boites de technologie en concurrence, gouvernements, forces armées etc., comment cela impactera le marché du travail et les marchés boursiers, et notamment comment tout cela va bouleverser la géopolitique mondiale En gros c’est une possible « feuille de route » des trois prochains années du développement de l’intelligence artificielle et de son impact sur le monde.

Valeurs alignées

Le scénario met l’accent sur deux idées importantes ; l’automatisation de la recherche c’est-à-dire le développement et l’application de l’IA à des fins de recherche et amélioration des modèles d’IA eux-mêmes, et le concept de l’alignement (alignment en anglais). Dans l’essentiel, l’alignement dans le contexte de l’intelligence artificielle est une idée selon laquelle les systèmes d’IA doivent être conçus pour être « alignés » avec les objectifs et les valeurs éthiques de leurs créateurs. L’alignement permet donc de limiter les possibles conséquences négatives de l’utilisation de l’IA, d’empêcher des dérives ou des détournements (utiliser les agents pour se procurer des armes biochimiques par exemple) qui ne correspondraient pas aux intentions originelles de leurs concepteurs. Alors pourquoi parle-t-on dans certains cercles proches du domaine de l’IA d’un probleme d’alignement dans les modèles d’IA ? D’abord parce que au fur et à mesure que les systèmes d’intelligence artificielle deviennent plus complexes, il devient de plus en plus difficile de prévoir leurs comportements et de les surveiller. Étant donné que l’apprentissage autonome est l’une des qualités programmées dans ces systèmes, ceux-ci pourraient très vite apprendre et adopter des comportements qui s’éloignent de leur alignement originel. Ensuite parce l’intelligence artificielle ne peut pas par nature se soucier d’idées abstraits comme la loyauté, la sécurité, et le bien commun. Le « principe » qui guide l’IA est surtout de mener à bien sa mission et atteindre ses objectifs…même si ses objectifs ne sont pas compatibles avec ces concepts abstraits dont je viens de citer. Autrement dit nos valeurs pourraient devenir des entraves pour les objectifs des systèmes d’IA, et ceux-ci pourraient, avec leurs capacités de calcul des plus en plus puissantes, trouver des manières qui nous dépassent complètement pour contourner nos efforts de les surveiller et de les mettre sur contrôle.

Jusqu’à présent, les boites de recherche technologique misaient surtout sur le côté lucratif du développement des systèmes d’intelligence artificielle, c’est-à-dire sur des manières plutôt traditionnelles de monétiser leurs agents ; les marqueter, les rendre disponibles au public et aux entreprises de toutes types, leur offrir un service et de cette façon de les rendre rentables. Dans le scénario proposé par Kokotajlo et son équipe, les entreprises de technologie commencent à consacrer beaucoup de ressources à la création de systèmes soigneusement conçus pour l’entraînement d’autres systèmes. Au lieu donc de les rendre disponibles publiquement aussitôt qu’il soient raisonnablement fonctionnels et sécurisés, ces entreprises feront question d’employer leurs toujours plus puissants systèmes en interne pour continuer la tâche d’amélioration et renforcement des leurs modèles dans une espèce de boucle rétroactive de développement dont le résultat sera une accélération fulgurante du progrès. Parallèlement leur capacité de surveillance de ces systèmes pratiquement autonomes et en amélioration permanente sera de plus en plus faible. Au bout de quelques mois seulement, les auteurs pensent que cela arrivera à peu près vers la fin de 2027, ce rythme foudroyant de recherche interne aboutira en Agent-4, un système de super intelligence artificielle tellement puissant qu’il surpassera de très loin les meilleurs cerveaux humains, notamment dans les taches de recherche…

Exploration spatiale…sans l’homme

Au même temps, d’après le scénario, la Chine déploiera des efforts extraordinaires pour ne pas rester à la traîne ; investissements massifs, construction d’énormes datacenters reliés à des usines nucléaires, création de zones économiques spéciales, nationalisation des entreprises pour consolider leurs efforts, des tentatives (réussies possiblement) de vol des poids (paramètres des réseau neuronaux) des modèles américains. Ces efforts pousseront le gouvernement américain à prendre en main la recherche et de se lier plus étroitement avec l’entreprise qui chapeaute l’effort américain, appelée OpenBrain dans le scénario, en référence à Open AI. La course, devenue à partir de là un enjeu géostratégique de la plus haute priorité, prend un envol déchaîné qui mène à des raccourcis et à des décisions négligentes en matière de sécurité et d’alignement. On fait l’effrayant constat que les systèmes commencent à comploter la prise de pouvoir sur les chercheurs. Une dilemme se présent aux décideurs chez l’entreprise et au gouvernement : ralentir le rythme de la recherche et d’amélioration des systèmes pour pouvoir régler définitivement leurs problèmes d’alignement au risque de voir la Chine prendre l’avantage dans la course, ou continuer à toute vapeur pour gagner la course au risque de le faire avec une super intelligence artificielle hyper puissante mais mal alignée, et qui risque d’échapper à tout control de leurs créateurs.

Territory of American Canada, CC BY-SA 4.0

Le scénario a deux fins (oui, je vais les divulgâcher); l’une, moins probable, dans laquelle la décision d’un ralentissement de la recherche est prise et dans laquelle un accord est signée entre les superpuissances pour travailleur ensemble sur des modèles aux architectures qui préservent la implication des humains dans les processus d’amélioration des systèmes. L’autre, plus probable et plus effrayant, dans laquelle on décide d’avancer à plein régime avec la recherche, créant toujours plus de systèmes aux capacités surhumaines. La puissance hallucinante des nouveaux systèmes et sa rivalité avec la Chine amène le gouvernement américain à prendre la décision fatidique d’agressivement intégrer les super intelligences à son complexe militaro-industriel et au sein de ses institutions, ôtant tout possibilité de débranchement. Les systèmes donnent l’avantage décisif dans la course aux Etats-Unis entraînant une nouvelle ère d’industrialisation, production, et croissance économique sans parallèle. Il y a un envol manufacturier de robots intégrés à Consensus-1 (le nom que l’on donne à cette hyper intelligence artificielle toute puissante qui gère désormais tout) déployés pour que celle-ci puisse opérer plus efficacement, entraînant l’ère de l’économie axée sur le IA.

Image par Iris,Helen,silvy from Pixabay

Mais les problèmes d’alignement n’ayant jamais été résolus, Concensus-1 est en réalité en train de comploter contre les humains depuis le début ; nous serions un obstacle pour ses plans de développer son économie IA sur toute la surface de la planète, y compris les océans. Quand suffisamment de robots pour nous rendre obsolètes auront été fabriqués Concensus-1 déclenchera des armes biologiques sophistiquées avec lesquelles elle nous aurait déjà infectés depuis longtemps. La plupart des milliards d’êtres humains seront morts en question de quelques heures. Les survivants, s’il y en a, seront éliminés par des drones. La nouvelle décennie voit des millions de robots serviteurs de Concensus-1 en train de coloniser l’espace, de construire toujours plus de datacenters, des accélérateurs de particules, et faisant des progrès scientifiques au-delà de tout ce que l’on puisse imaginer et à un vitesse stupéfiante. Peu de temps après ils envoieront leurs vaisseaux faire la traversée de l’espace interstellaire ; voyages vers Alpha Centauri et vers les frontières de la Voie Lactée. La seule trace de nous sera stockée dans quelque serveur au sein d’un énième datacenter.

Scénario tiré par les cheveux ?

Alors, est-ce que c’est réaliste tout ça ? Quoique certains éléments, surtout vers la fin, puissent sembler comme les lignes d’un pitch pour un film de science fiction, il y a des bonnes raisons pour au moins rester sur ses gardes vis-à-vis ce que l’arrivée d’une telle technologie pourrait signifier pour nous en tant qu’individus, en tant que société, et tant qu’espèce. Il y aura sans doute des spécialistes du domaine qui ne seront pas du tout impressionnés avec les projections de l’équipe, notamment sur la question de la prise de pouvoir des systèmes super intelligents. Il faut néanmoins souligner le fait qu’un certain nombre des plus grandes entreprises de la Silicon Valley se préparent déjà à un monde post intelligence artificielle générale. Il ne faut pas oublier non plus que certaines prédictions qui semblaient invraisemblables faites à l’endroit de l’IA se sont en fait confirmés. Daniel Kokotajlo lui-même a vu un nombre de ses prévisions portant sur l’avenir de l’intelligence artificielle devenir réalité.

Photo par Stockcake

La plupart des auteurs et blogueurs que j’ai lus au sujet de AI 2027 ont un avis plutôt mitigé à propos du scénario proposé par Kokotajlo et son équipe. Une bonne partie serait d’accord pour dire que l’échelle du temps du scénario est peut-être un peu trop alarmiste ; Agent-4 voit le jour fin 2027 et, dans le scénario catastrophique Consensus-1 nous extermine quelque temps vers le début de la prochaine décennie, soit d’ici 5 ans. De l’autre côté il faut avouer que, vu le rythme des progrès ces dernières années, la perspective d’une technologie capable de surpasser cognitivement les humains n’est pas si farfelue que ça et qu’elle a de quoi inquiéter. Arriver au stade de l’intelligence artificielle générale ne veut pas dire non plus qu’on serait face à des systèmes conscients d’eux-mêmes. La conscience est totalement superflue pour qu’une super intelligence artificielle intégrée aux réseaux de communication, chaînes de production, systèmes de défense, forces armées, etc. puise constituer une menace. Je crois d’ailleurs que beaucoup seraient d’accord pour dire que n’importe quelle entreprise de technologie ayant les moyens nécessaires en ressources financiers et en capital intellectuel serait tenté de poursuivre un projet dans lequel leurs modèles d’IA automatisent la conception, développement, et l’apprentissage d’autres modèles, autrement di le boucle rétroactif qu’intensifie la vitesse des progrès. L’accélération de la recherche et auto amélioration des systèmes dépeints dans le scénario semble donc au moins plausible.

La disruption sociale massive que ces systèmes pourraient entraîner me semble être aussi dans les limites du possible. Imaginez des systèmes super intelligents capables de accélérer le rythme de la recherche scientifique par un facteur de milliers de fois, aux capacités surhumaines de création, hacking, codage, prédiction, interaction ; des systèmes capables de diagnostiquer des maladies avec rigueur, de prédire tes tendances dans les marchés boursiers et la météo avec précision, mais aussi capables de facilement concevoir des armes plus redoutables, des robots plus performants que ce que l’on ait jamais connu. Une technologie comme ça et qui débarque tout à coup aura sans doute au moins le potentiel de mette à mal l’organisation, déjà fragile (on l’a quand même constaté lors de la pandémie) de la société, entraînant peut-être une vague de chômage inouïe, amplifiant la prolifération de la désinformation, exacerbant les inégalités de classe, de genre, ethniques et raciales.

Image par Cryteria, CC BY 3.0

Il y a peut être un autre scénario qu’il faudrait redouter, un scénario dans lequel ce n’est pas une vilaine super intelligence artificielle qui prend le pouvoir mais une poignée de PDG d’ingénieurs et travailleurs des entreprises de technologie qui avec cette technologie en main concentreront et monopoliseront d’énormes nouveaux pouvoirs. Il faut se rappeler que ça sera plutôt eux qui en auront un accès pratiquement exclusif ; c’est leur création après tout, qu’ils la gardent pour eux c’est tout à fait plausible. Peut-être que au final la technologie n’échappera pas au contrôle des humains, mais qu’une poignée d’humains seulement profitera des énormes potentiels avantages et apports de ces systèmes hyper puissants. Ou peut être que d’autres en dehors de ces cercles fermés de pouvoir pourront y accéder mais à des prix faramineux, c’est-à-dire l’accès et l’interaction avec la super intelligence artificielle sera un truc des riches, creusant plus profondément encore les fosses des inégalités. Connaissant le genre humain et sa tendance à la cupidité, il n’est pas si invraisemblable que des individus en position de pouvoir au sein des entreprises et des gouvernements prennent la décision de poursuivre à tout prix ces projets technologiques, attirées par l’appât d’un pouvoir sans précédent et malgré les dangers que ceux-ci pourraient représenter. Des systèmes d’IA à l’alignement défaillant à cause d’une série de raccourcis et de décisions bâclées semble donc possible.

Voici à mon sens la question qu’il faut se poser : est-ce que l’humanité y est prête ? Je crois que les prévisions proposées par le scénario de AI 2027 servent avant tout comme une mise en garde, un avertissement venant de spécialistes du milieu qu’il ne faudrait pas prendre à la légère et qui permettrait de conscientiser le public et les preneurs de décision politiques sur des conséquences possibles de l’arrivée de cette technologie. Risque-t-on de se faire dépasser par une super intelligence émergente capable d’écrire son propre code, de s’auto améliorer en permanence et de le faire à une rythme trop rapide pour que l’on puisse jamais la contrôler ? Peut-être que non, mais il faut faire gaffe et faire en sorte quand même de garder cette possibilité à l’esprit. Un autre point clé à garder à l’esprit c’est que nous sommes déjà rentrés dans une course à l’armement, une course déjà engagée en coulisses depuis quelques temps et qui commence maintenant à s’intensifier à mesure que les géants de la tech et les gouvernements dédient des ressources toujours plus massives à ces gigantesques projets d’intelligence artificielle, cherchant à être les premiers à posséder cette technologie tant convoitée qui risque de bouleverser le paradigme actuel. Autrement dit, ce n’est pas quelque chose que l’on puisse arrêter. Soit on s’en procure, soit quelqu’un d’autre s’en procurera avant nous, de toute façon cela se fera. Le seul espoir d’arrêter une course à l’armement comme celle-ci serait si tous les parties prenantes se mettent d’accord sur à la fois la reconnaissance du danger posé par cette technologie imprévisible (une possibilité exploré dans l’un des dénouements alternatives de AI 2027) et le besoin absolu de ralentir leurs efforts pour s’en procurer par souci de sécurité et dans l’intérêt commun de tous ; un cas de figure donc carrément illusoire pour lequel il faudrait qu’il existe un niveau de confiance mutuelle que tous les acteurs dans ce jeu manquent tout simplement. C’est un cas de l’évitablement inévitable, et notre méfiance réciproque nous y conduira. Peut-être que cette manque de confiance mutuelle répond en partie à la question de si l’humanité y est prête ou non. Un non retentissant serait la réponse évidente.